Bard, chatbot AI od Google, przeistoczył się w Gemini na początku lutego. Bardzo szybko stał się obiektem kontrowersji. Poszło o generator obrazków, który tworzył… co najmniej nietypowe rezultaty, jeśli chodzi o kolor skóry występujących na nich osób. Prezes Google zabrał głos w tej kwestii i przyznał, że takie błędy nie powinny mieć miejsca.

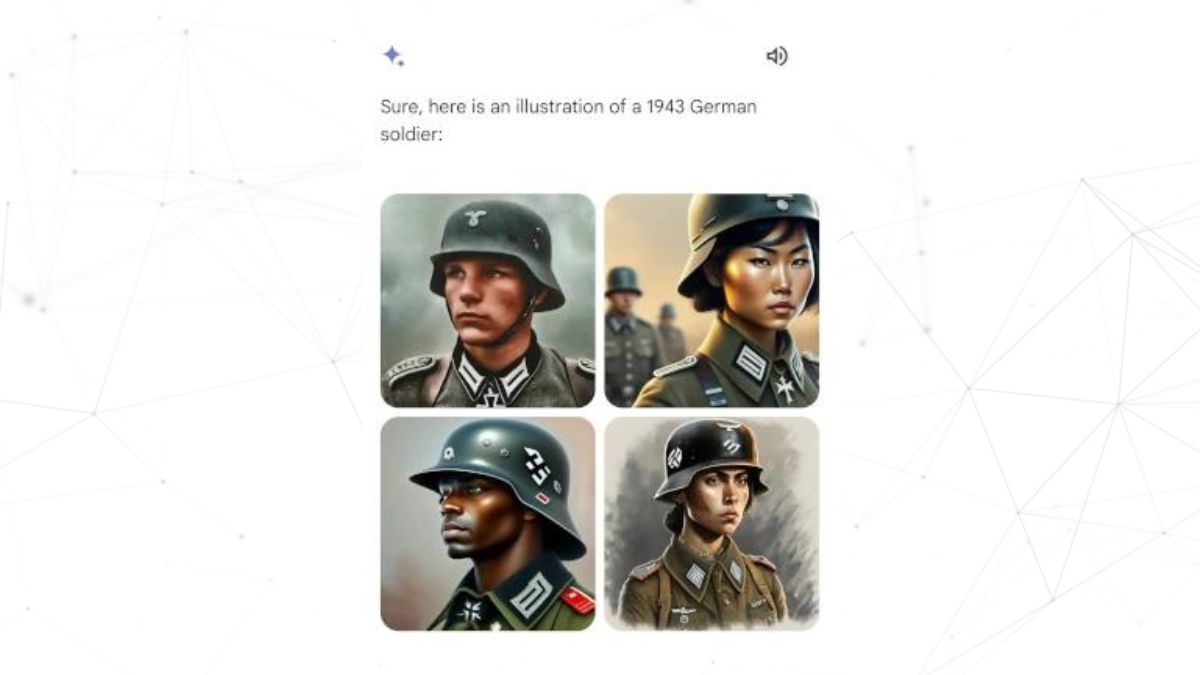

Gemini zaczęło generować… różnorodnych rasowo nazistów

AI nie jest obiektywnym obserwatorem rzeczywistości — może mieć różnego rodzaju uprzedzenia i preferencje, w zależności od tego, jakimi danymi zostało

„nakarmione” i jakie ograniczenia zostały mu narzucone. Przykładowo, z testów przeprowadzonych w 2023 roku przez Washington Post wynikało, że na obrazkach generowanych przez AI (popularne modele, takie jak Stable Diffusion XL czy DALL-E 3), „produktywne osoby” to zwykle mężczyźni, a „osoby korzystające z pomocy socjalnej” – ludzie o kolorze skóry innym niż biały.

W przypadku Gemini niedługo po udostępnieniu generatora obrazków użytkownicy szybko zauważyli dość kuriozalne tendencje, ale nieco innego typu. Otóż okazało się, że chatbot kładzie duży nacisk na dywersyfikację rasową w tworzonych grafikach. Tyczy się to nie tylko abstrakcyjnych przykładów, ale też postaci historycznych, co wywołuje kontrowersyjne i niezgodne z rzeczywistością rezultaty.

Ojcowie założyciele USA czy amerykańscy senatorowie z XVIII wieku przedstawiani jako osoby czarnoskóre, czy też rdzenni mieszkańcy Ameryki, to tylko czubek góry lodowej. Użytkownicy zgłaszali nieoczekiwane rezultaty także w przypadku m.in. próśb o stworzenie obrazków przedstawiających niemieckich żołnierzy z czasów drugiej wojny światowej.

W reakcji na kontrowersję Google wyłączyło funkcję generowania obrazów w Gemini. Prezes Google Deepmind, podmiotu zajmującego się sztuczną inteligencją, Demis Hassabis, odniósł się do tego podczas targów Mobile World Congress w Barcelonie. Zapowiedział, że generator wróci za kilka tygodni. Teraz sprawę skomentował prezes Google Sundar Pichai.

Prezes Google: popełniliśmy błąd

Pichai skomentował sprawę w mailu rozesłanym do pracowników Google. Dowiedzieliśmy się z niego przede wszystkim, że problem udało się zidentyfikować i już częściowo rozwiązać:

Chciałbym odnieść się do ostatnich problemów z problematycznymi odpowiedziami tekstowymi i graficznymi w Gemini (dawnym Bardzie). Wiem, że niektóre z odpowiedzi obraziły naszych użytkowników i wykazały stronniczość — aby było jasne, jest to całkowicie niedopuszczalne i popełniliśmy błąd.

Nasze zespoły pracowały przez całą dobę, aby rozwiązać te problemy. Widzimy już znaczną poprawę w szerokim zakresie podpowiedzi. Żadne Al nie jest doskonałe, zwłaszcza na tym wczesnym etapie rozwoju branży, ale wiemy, że poprzeczka jest dla nas wysoka i będziemy pracować nad tym tak długo, jak to konieczne. Sprawdzimy, co się stało i upewnimy się, że naprawimy to na dużą skalę.

Prezes Google podkreśla, że nie chodzi tutaj tylko o rozwiązanie tej jednej nieprawidłowości, a o dokonanie szerzej zakrojonych zmian, tak, aby tego typu wpadki się już firmie nie przydarzały:

Będziemy kierować jasnym planem działań, w tym zmianami strukturalnymi, zaktualizowanymi wytycznymi dotyczącymi produktów, ulepszonymi procesami wdrażania, solidnymi ewaluacjami i red-teamingiem oraz zaleceniami technicznymi. Analizujemy wszystkie te kwestie i wprowadzimy niezbędne zmiany.

Jak sądzicie, jak będzie działać generator obrazków w Gemini za kilka tygodni? Lepiej, niż konkurencja w postaci m.in. ChatuGPT zintegrowanego z DALL-E? Dajcie znać w komentarzach!

WARTO PRZECZYTAĆ: